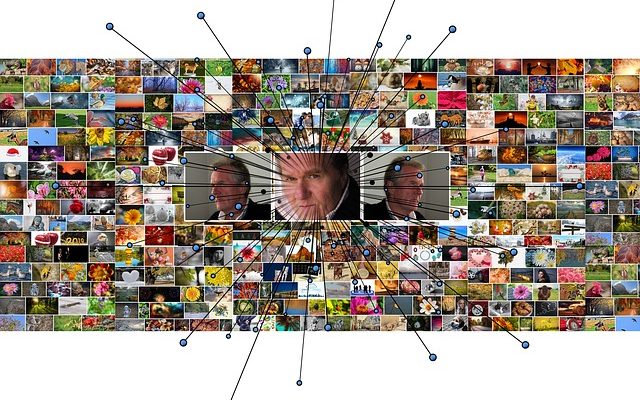

ディープフェイク(ディープラーニングを用いて写真や映像に別人の顔を合成する技術)に関する重要なニュースが立て続けに2つ報道されている。

オンラインのディープラーニング動画の数が急増中。大部分はポルノ(CNN)

- アムステルダムのサイバーセキュリティ企業Deeptraceがディープフェイク動画を集計

- 2018年12月に7,964個だったのに対し、2019年7月には少なくとも14,678個存在(84%増)

- その96%はポルノコンテンツ(その全ては女性を取り上げている)

- その大半は9つのディープフェイク特価のアダルトサイトに存在

- インターネット上の動画の数から見れば微々たる量に見えるが、ソーシャルメディアを介した政治への影響など脅威である

- 250枚の写真を使って3ドルで2日間で任意の人のディープフェイク動画を作成できるサービスなど低価格

カリフォルニア州、選挙とポルノ関連のディープフェイク動画を取締り対象へ(engadget日本版)

- カリフォルニア州がディープフェイクに関する2つの法律を承認

- 1つ目:選挙まで60日以内に、有権者を騙すことを目的とした動画の拡散を違法化

- 2つ目:州内に住む人がディープフェイクを用いて自身の画像がポルノ動画に合成された場合は作成者を告訴可能

- 著名人のイメージ侵害、リベンジポルノなどへの悪用、政治面など危険性が高い

- アメリカ自由人権協会は、法律について「有権者の混乱や悪意ある訴訟、言論の自由の抑圧をもたらすだけのものになる」とし、問題の解決にならないと表明

補足

GAN(敵対的生成ネットワーク)により別人の動画や写真への顔合成技術が発達したことがポルノ・政治に関して大きな問題となっている。

ディープフェイクと言っても、偽物と見分けが殆どつかないものからお粗末なものまで多くあるが、今のところ質がまちまちなのはGANの学習パラメータの調整が難しいからである。

GANでは、画像などが持つ特徴量の確率分布を学習する上で、偽物を作成するニューラルネットワークと、偽物を見破るニューラルネットワークを作り、競わせながら学習させるのだが、実際にやってみると両方のバランスを取るのは非常に難しいことが分かる。

偽物を作る方が先に成長し過ぎると、もう一方が全く見破れなくなって学習が進まなくなり、逆でも同様の問題が起こる。両方とも少しずつ成長するように調整するのは大変なのだ。

それはともかく、Deeptraceによるディープフェイク動画の定量化は興味深い試みであり、それと法制定の動きが早いカリフォルニア州で上記の法律が承認されたことは、いかに問題が深刻であるかがよく分かる。

ディープフェイク動画の96%がポルノであることは特段驚くべきことではない。そもそも、世の中のウェブサイトの4%はポルノサイトだし、ウェブ検索の13%はポルノに関するもの、モバイル検索にいたっては20%がポルノに関するものだ。

ディープフェイクは人権侵害を伴うので、アメリカ自由人権協会の言い分もよく分かる。 しかし、ディープフェイクに関しては技術がある程度確立してしまっているので、カリフォルニア州のような、自衛や被害の救済の方向から取り締まるのは無難であろうと思う。

11月12日追記

政治だけでなく民間企業側からも具体的な対策が進んできているので別記事を投稿した。

Adobe, Twitter, NYTがディープフェイク対策を提案

参考文献

CNN, “The number of deepfake videos online is spiking. Most are porn”, 7 Oct 2019

engadget「カリフォルニア州、選挙とポルノ関連のディープフェイク動画を取締り対象へ」2019年10月7日

statista, “How Much of the Internet Consists of Porn?”, 11 Feb 2019